はじめに

『表象ってナンだ?』

『表象(Representation)』ってなんでしょう……。最近、『表象』やそれに関連する抽象的な概念についての本を読んでますが、なんとなくの理解しかできてません。思考や図を描いての整理だけでは、なかなか納得できない部分もあります。

そういうわけで、簡単なシミュレーションの実験をして理解を深めたいと思います。今回は、『複数の感覚からの知覚』と『表象』について実験していきます。

※注:本記事は、勉強中の自分の理解で書いているもので正確でない可能性が高いです。

表象について

表象というのは、心の中に形成されるものだそうです。「そもそも心ってなんだよ!」とは思いますが、それは無視しておきます。そして、心の中に形成されるものといっても、以下のように形成の仕方はいろいろあるようです。

- 対象を知覚することにより心に表れる表象

- 記憶から心に表れる表象

- 思考によって心に表れる表象

場合によっては、知覚によるものは表象に含まないこともあるようですが、本記事では含むとします。また、記憶による表象と思考による表象は今回は考えません。

知覚表象

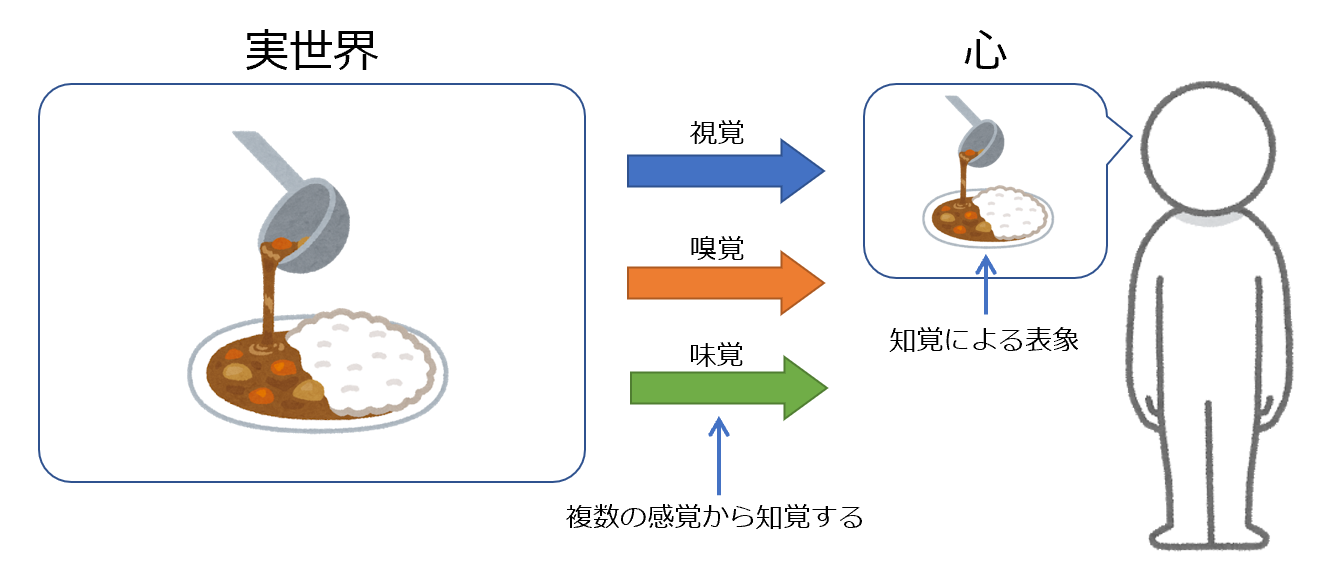

知覚によって生じた表象である知覚表象を図にしてみます。

この図では、カレーの表象を心の中に形成するのに、視覚・嗅覚・味覚という複数の感覚から知覚しています。視覚・嗅覚・味覚が認識する性質はそれぞれ異なります。例えば、視覚は色や形という性質を認識しますが、嗅覚はそれらを認識することはできません。人は、これらの感覚が認識する性質を組み合わせて表象を形成することができているようです。

後の実験では、この複数の感覚による知覚表象についての理解を深めたいと思います。

実験

今回の実験のモチベーションは、『複数の感覚で認識した性質を組み合わせて表象を形成するというのはどういうことだろう?』という疑問です。表象を形成するために、複数の感覚を統合しているわけですが、統合しないとどうなるのか・統合するというのはどういうことなのかについて理解を深めたいと思います。

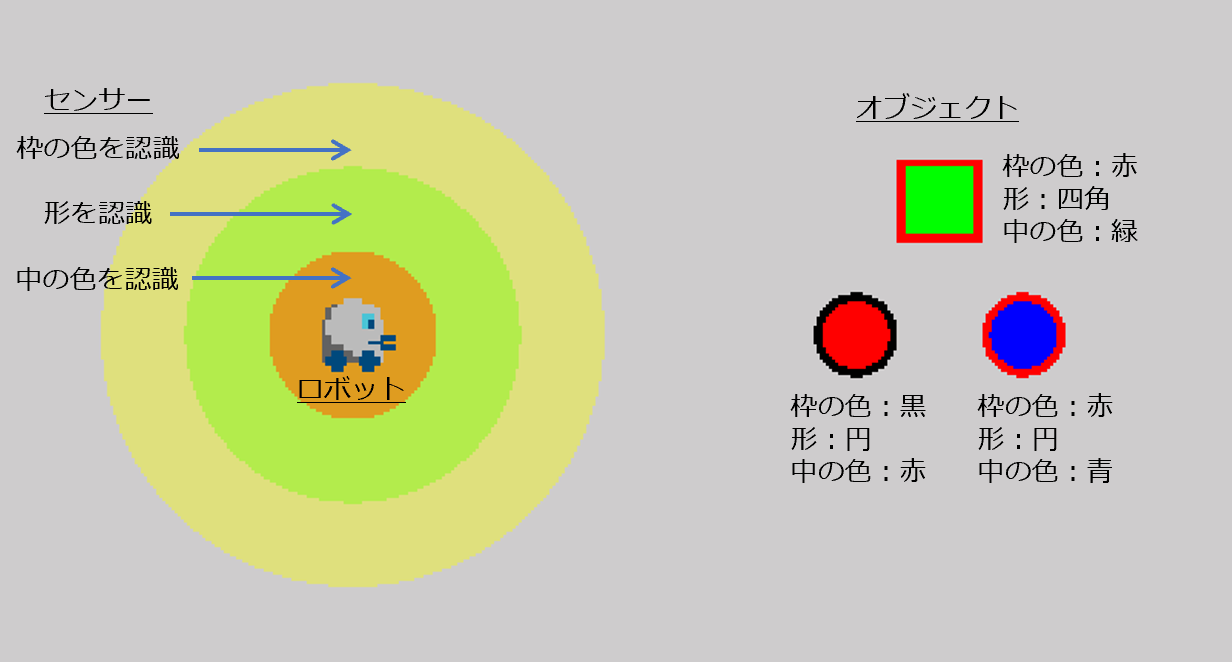

生物の代わりに次のような仮想のロボットで実験したいと思います。ロボットは、感覚の代わりに以下のような3つのセンサーで対象のオブジェクトの形や色の性質を認識します。それぞれのセンサーは、範囲に含まれるオブジェクトの性質のみ認識できるとします。こんな単純なロボットで表象について考えるのは不自然かもしれませんが許容するとします。

- 大サイズのセンサーは、オブジェクトの枠の色を認識する

- 中サイズのセンサーは、オブジェクトの形(円や四角)を認識する

- 小サイズのセンサーは、オブジェクトの中の色を認識する

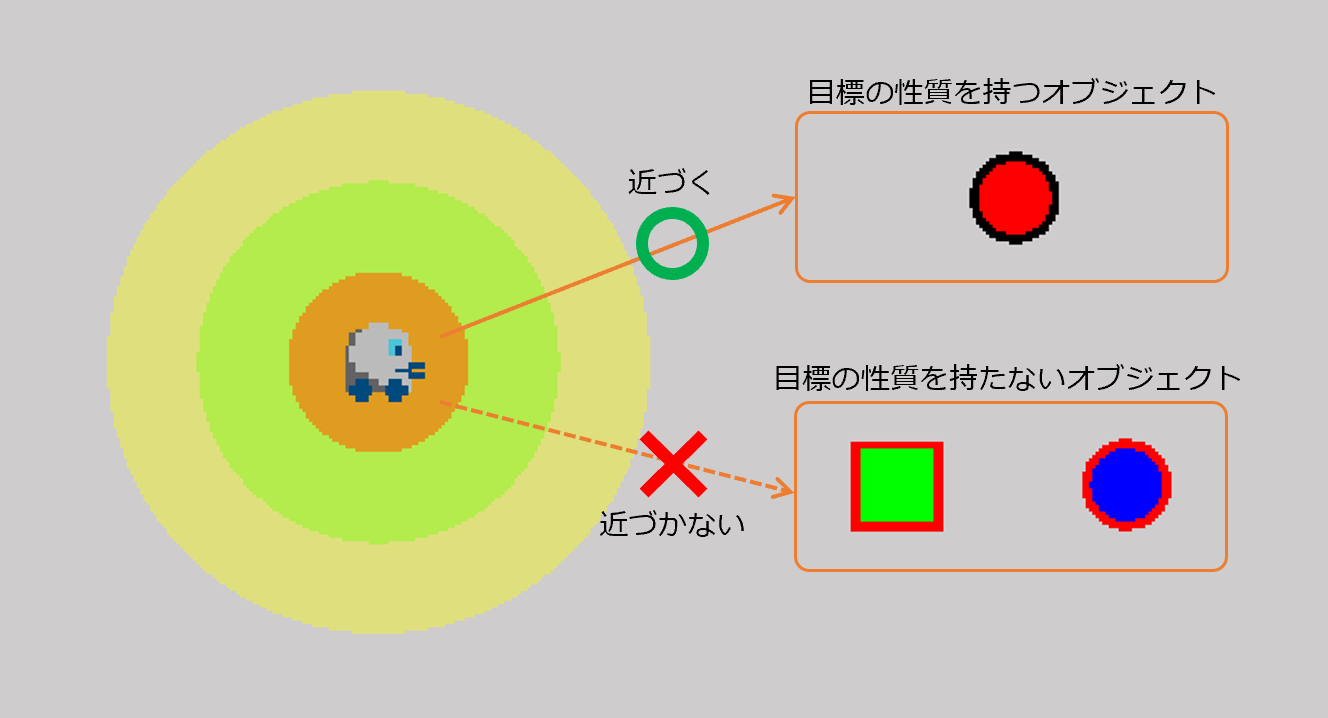

このロボットは、枠が黒・形が円・中が赤の性質を持つオブジェクトを目標とすることにします。その目標のオブジェクトには近づいて、そうでないオブジェクトには近づかないという挙動になるようにします。

以降、センサーによる認識も感覚による認識とし、感覚を統合しないケース・感覚を統合するケースについて見ていきます。

感覚を統合しないケース

ロボットは、以下のようなシンプルな挙動をするとします。

実際に動かしてみると、対象が目標のオブジェクトの場合には問題ないです。しかし、対象が目標のオブジェクトでない場合に、1つの対象に対して異なる表象を形成すると下図のように動いてしまうことがあります。

(なんだか夜中に電球にアタックしている昆虫のような動きです。昆虫は感覚を統合せず表象を形成しているのでしょうか)

感覚を統合できないということは、効率的に目標に向かうのに障害になるであろうことがわかります。

感覚を統合するケース

感覚を統合することで、同じ対象を複数の感覚で認識することができます。これにより、1つの対象に対して1つの表象を形成できます。「これで問題解決だぜ。やったー!」と言いたいところですが、実装しようとすると、新たな問題が出てきます。異なる器官で認識したものをどうやって同じ対象由来と判別するかという問題です。

今回は、この問題に対して、同じ位置にあるものは同じオブジェクトであるという仮定をして実装しました。これは、現実世界では複数の異なるオブジェクトが同じ位置で重なりあっていることは基本的にないからです。

実際に動かしてみて感覚を統合しないときに生じた問題は発生しないことは確認できました。

まとめ

感覚を統合しないというのは、直感的に効率的ではないということは感じてましたが、実際に動かしてみて確認することができました。

一方で、感覚を統合して1つの対象から1つの表象を形成することの難しさを実装することによって発見できました。実際に人がどのように対処しているかは不明ですが、なんとかうまいことしてるんでしょうね。人って賢いな~と思います。今回の実装では位置を手がかりにしましたが、おそらく不十分でしょう。なぜなら、今の仮定ではオブジェクトが動いたりする場合にうまく対処できないからです。ここは将来的にもう少し理解を深めたいです。

余談

表象は、実際に生物の仕組みに同等のものがあるとは限らず、実装して実験する価値があるのか分からないということもあり、書いている途中に心折れかけました(直近、役に立つ話でもないし…)。また、説明を書くにも使用する言葉が抽象的で正しいのか不明な部分が多くかなり苦労しました。ただ、表象については、他にも理解したいことがあるので、のんびり進めていこうと思います。

ちなみに、今回のようなテーマでもっと実践的なことをしたい場合は、マルチモーダル学習について研究すると良さそうです。